Intelligenza Artificiale, doppio standard e discriminazioni in Europa

Bill Gates a Palazzo Chigi chiede mani libere al governo italiano che presiederà il G7 e coordinerà il dossier sull’Intelligenza Artificiale. Le recenti linee guida Ue vanno verso questa deriva: doppio standard di diritti, tra europei e migranti, e spazi per sorveglianza biometrica, senza spazio a controlli terzi.

L’approdo a Roma di Bill Gates, massimo esponente del colonialismo filantrocapitalista, e dominus anche dell’Intelligenza Artificiale dopo che la sua Microsoft si è impadronita con colpi di mano e miliardi di OpenAI, appare molto simile all’arrivo del monarca che viene a istruire i governatori locali sui suoi desideri riguardo la tecnologia da lui controllata. La presidenza del G7 quest’anno sarà dell’Italia, e il governo italiano ha già ben mostrato, al di là della retorica qualche volta esibita, il suo allineamento alle richieste di deregolamentazione del settore che provengono dalle aziende tecnologiche. Del resto, il pensiero di Gates a proposito appare molto semplice: “L’importante è che la IA sia in mani giuste”. Mani salde che ne sappiano utilizzare le capacità, non permettendo alcuno sviluppo o deviazione democratica della tecnologia. E su questo, al di là dei proclami esibiti in Europa, non sembra ci sia dubbio alcuno.

L’

Quando, nell’aprile del 2021, la Commissione Europea propose l’istituzione di un atto legislativo allo scopo di regolare l’Intelligenza Artificiale (IA) 1, la gran parte degli osservatori accolse con favore l’evento, primo esempio nel mondo verso una normativa con il dichiarato obiettivo di porre al centro dell’attenzione la salvaguardia dei diritti di cittadinanza rispetto all’espandersi incontrollato e pervasivo delle tecnologie della IA.

Nonostante il clamore sviluppato da quel primo documento propositivo, la definizione di un testo “politicamente condiviso” da parte delle istituzioni europee 2 si è conclusa solo nello scorso dicembre, verosimilmente anche in seguito al clamore suscitato dall’apparizione pubblica di ChatGPT 3. L’accordo, enfaticamente definito storico, avrebbe l’ambizione dichiarata di porre le linee di riferimento democratiche nella gestione delle problematiche connesse alla Intelligenza Artificiale, nonchè di fare da riferimento per ogni futura normazione al riguardo, anche al di fuori dell’Unione Europea. Singolarmente però fa clamore l’assenza di qualsiasi documento ufficiale che ne divulghi i contenuti, la cui diffusione è rimasta affidata ad una conferenza stampa 4, ai comunicati stampa della Commissione e del Consiglio europei 5. Già questo lascia intendere come quelle stabilite siano semplici linee generali e che quanto raggiunto non sia ancora del tutto stabilizzato: saranno i dettagli tecnici a dare forma definita all’European Artificial Intelligence Act (EU AI Act). Nella conferenza stampa di presentazione si è parlato di “accordo equilibrato”. Certamente, le linee di salvaguardia, nei confronti della pervasività che l’IA rende possibile, sono enunciate dalla norma, tuttavia quel che finora traspare è un accordo che nei fatti costruisce standard differenziati per categorie di cittadinanza, che vanno da un vero e proprio doppio standard esplicitato nei confronti dei cittadini migranti, per i quali è codificata l’assenza di protezione dall’uso improprio degli algoritmi, alla plurima presenza di “porte sul retro” con cui poter aggirare i diritti di cittadinanza altresì affermati per i cittadini europei: backdoors che appaiono essere, più che eccezioni, linee guida di aggiramento per le attività di controllo digitale e previsionale che la norma afferma di voler contrastare. A chiudere un quadro certamente già non positivo, il demandare alle aziende il giudizio di conformità rispetto al rischio, lasciando loro, senza alcun obbligo di trasparenza, le valutazioni del caso.

L’European Artificial Intelligence Act: quel che sappiamo dell’accordo del dicembre 2023

L’accordo politico raggiunto lo scorso dicembre definisce come sistemi di Intelligenza Artificiale quei sistemi basati su dispositivi che, per obiettivi espliciti o impliciti, possiedono capacità, a partire dall’input che ricevono, di generare output quali previsioni, contenuti, raccomandazioni o decisioni, tali da influenzare ambienti fisici o virtuali. Tale definizione riprende la definizione OCSE.

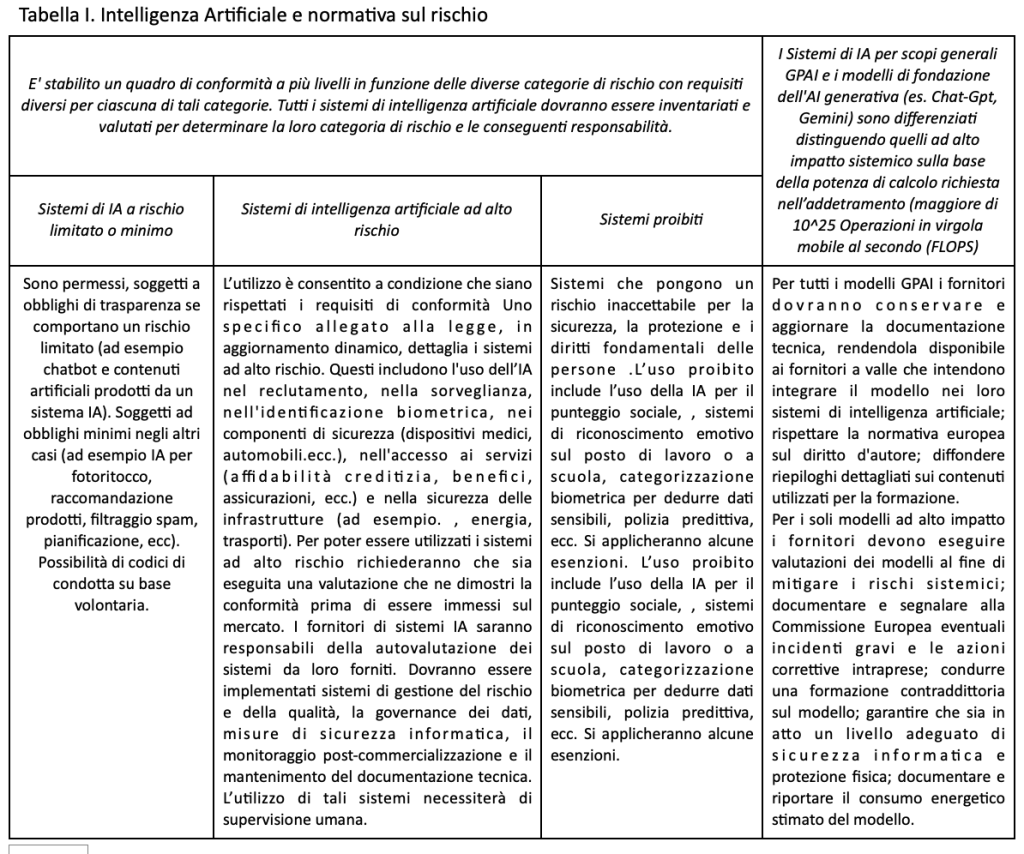

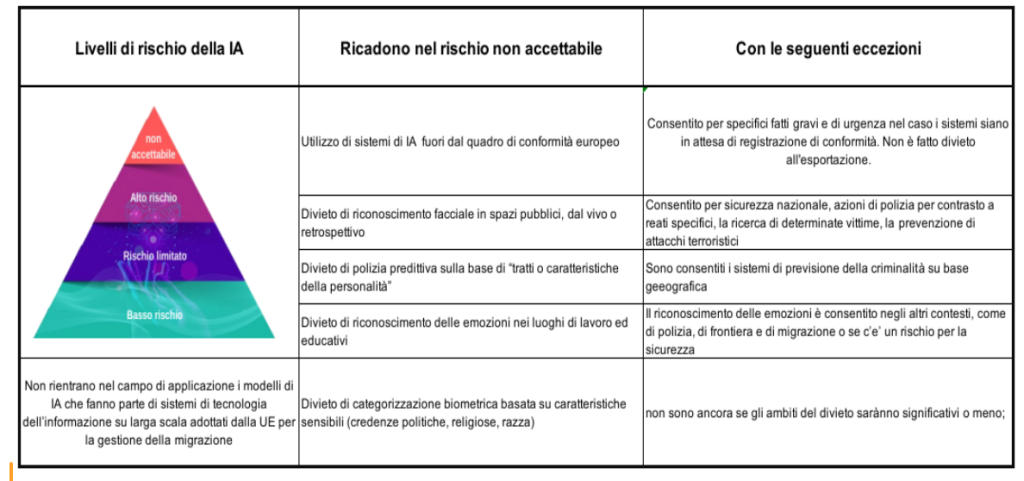

I sistemi di IA sono classificati sulla base del livello di rischio che comportano in termini di sicurezza, incolumità o diritti fondamentali delle persone. Il livello di rischio deriva dal modo in cui un sistema di Intelligenza Artificiale viene utilizzato, non dalla tecnologia su cui si basa. I sistemi di IA per scopi specifici sono differenziati in: sistemi a rischio trascurabile o minimo, sistemi ad alto rischio e sistemi proibiti.

Si stabiliscono obblighi di conformità differenziati in funzione del livello di rischio che i sistemi di IA comportano, la cui valutazione di rischio è però a carico degli stessi sviluppatori e dei distributori. Ove le autorità pubbliche utilizzino sistemi di IA ad alto rischio, questi dovranno essere registrati in una banca dati pubblica europea. Per l’utilizzo nella gestione della migrazione, si prevede una parte non pubblica della banca dati, mentre dalla norma sono esentati gli utilizzi dei sistemi per definiti scopi di polizia e scopi di sicurezza nazionale. In casi di urgenza, possono essere utilizzati dalle autorità di polizia sistemi ad alto rischio ancora in attesa della validazione di conformità.

Per quanto riguarda i sistemi di Intelligenza Artificiale per scopi generali (al momento ben rappresentati da Chat-GPT) la legge considera i rischi sistemici che possono derivare dal loro utilizzo e dai modelli di fondazione 6 ad essi sottostanti. I modelli GPAI avranno obblighi aggiuntivi, in funzione della potenza di calcolo utilizzata per il loro addestramento.

In tutta l’UE saranno messi a disposizione sistemi isolati (“sandbox”) affinché gli operatori (in particolare le piccole e medie imprese) possano accedervi volontariamente. L’applicazione delle norme avverrà gradualmente, a partire dai sistemi di IA vietati nel 2025 ed estendendosi a tutti i sistemi di IA entro la metà e la fine del 2026.

Sono stabilite sanzioni, le multe possono arrivare fino al 7% del fatturato annuo per l’utilizzo di sistemi di IA vietati, mentre il mancato rispetto dei requisiti per i sistemi di IA ad alto rischio sarà soggetto a multe fino al 3%.

Ogni singolo Stato avrà poteri di supervisione sull’applicazione delle norme, mentre a livello comunitario verrà istituito un ufficio centrale sulla IA all’interno della Commissione UE, con indipendenza funzionale, che avrà responsabilità di supervisione sui modelli GPAI (General purpose Artificial Intelligence), avvalendosi anche di un gruppo scientifico di esperti di supporto. Sarà istituito un forum consultivo con rappresentanti dell’industria e della società civile.

Nella Tabella I sono riportate, in un veloce sommario, alcune delle caratteristiche salienti dell’accordo politico raggiunto sull’EU AI Act.

Accordo storico e diritti civili salvaguardati?

Il doppio standard nei confronti della migrazione

L’attenzione ai diritti civili e di cittadinanza nello sviluppo dell’AI Act è stata sempre controbilanciata dalla dichiarata volontà di non deprimere le capacità di sviluppo della tecnologia nel contesto europeo. Questo si è tradotto in un continuo braccio di ferro istituzionale tra due orientamenti divergenti, uno teso alla salvaguardia ferma dei diritti e l’altro proteso verso lo sviluppo del mercato. Tale braccio di ferro, pur producendo risultati al di sotto delle dichiarate aspettative iniziali, ha comunque consentito l’emergere di un dibattito tra le istituzioni europee, e di una capacità di approfondimento sui danni potenziali di una tecnologia altrimenti subìta in modalità del tutto passiva.

La dialettica sopra descritta non si è neanche avviata per quanto riguarda l’applicazione nei confronti dei cittadini migranti. Nonostante gli appelli diffusi dalla società civile7 , sin dalla sua prima stesura, la proposta della Commissione sull’AI Act rende legale l’esistenza di un doppio standard, dimostrata dall’esclusione esplicita 8 ,dal campo di applicazione della norma, dei sistemi di IA che fanno parte dei sistemi su larga scala dell’UE, come Eurodac, il sistema d’informazione Schengen, e di ETIAS 9.

La capacità dei sistemi europei di governance dei confini è di oltre 300 milioni di registrazioni. Questo comporta il trattamento automatizzato di dati personali e sensibili, sistemi automatizzati di valutazione del rischio o l’uso della tecnologia per l’identificazione biometrica. L’UE prevede di sottoporre nei prossimi anni tutti i richiedenti di visto e i migranti inseriti in altri database dell’UE 10, a tecnologie automatizzate di profilazione del rischio. Inoltre è attualmente in corso di valutazione un aggiornamento di Eurodac per includere l’elaborazione delle immagini facciali nei database dei richiedenti asilo. In ogni caso le garanzie previste dalla legge UE sull’IA non si applicano per la migrazione e la registrazione in un database non pubblicamente accessibile dei sistemi ad alto rischio utilizzati non pare proprio essere uno strumento in grado di attenuare i danni potenziali in una seppure minima maniera11.

Durante l’intero processo migratorio vengono utilizzati sistemi di Intelligenza Artificiale: prima dell’ingresso, durante l’ingresso, durante il soggiorno e al ritorno. I sistemi di Intelligenza Artificiale, infatti, sono oggi parte integrante e caratteristica tendenzialmente generalizzata dell’approccio dell’Unione europea nei confronti della migrazione. Automatizzazione dei controlli ai confini, previsioni e valutazioni predittive del rischio di attività illegali, analisi delle emozioni dei singoli cittadini, utilizzo di sistemi robotici nelle aree costiere o di sistemi di analisi tesi a prevedere le tendenze migratorie, sono pratiche correnti utilizzate da governi e istituzioni, tali da essere parte fondante del modo in cui questi istituzioni rispondono alla migrazione. Un ulteriore danno verso i cittadini migranti, e contemporaneamente la piena dimostrazione del doppio standard di cittadinanza nei loro confronti, è rappresentato dall’esternalizzazione dei confini al di fuori dell’Unione Europea. Negli ultimi tre decenni, questa è stata un principio fondamentale della strategia dell’Unione Europea per gestire i flussi migratori. I paesi nordafricani, in prima linea nei piani di esternalizzazione dell’UE, diventano ora anche banco di prova tattiche e pratiche che vedono anche applicazioni diffuse dell’Intelligenza Artificiale. L’uso dei fondi dell’UE, anche quelli dedicati gli aiuti allo sviluppo, è finalizzato all’esternalizzazione delle tecnologie di sorveglianza sulle persone in movimento, oltre che, spesso, sulla popolazione locale.

A chiudere un quadro di costante violazione dei diritti è anche da considerare il fatto che l’uso dell’Intelligenza Artificiale nel controllo della migrazione viene effettuato principalmente da operatori del settore privato, a dispetto della competenza di autorità pubbliche statali della sua gestione. Essendo gli attori privati contemporaneamente i principali attori nello sviluppo di queste tecnologie, si viene a creare una situazione di mancanza di barriere, che sarà sfruttata dai medesimi attori privati per implementare e vendere nuovi prodotti, aprendo la strada a una corsa verso l’uso di tecnologie sempre più invasive per prevenire o scoraggiare la migrazione. Con il risultato di promuovere rotte sempre più pericolose e precarie per le persone che vogliono sfuggire al controllo.

La normazione dei sistemi in base al rischio

La presenza di obblighi di valutazione sull’impatto che i sistemi di IA posti in commercio possono avere sui diritti fondamentali delle persone, così come la presenza di obblighi di trasparenza pubblica dei sistemi di Intelligenza Artificiale ad alto rischio, è cosa che richiederebbe una valutazione positiva, se fosse accompagnata da una effettiva – e normata – capacità di valutazione e di controllo degli algoritmi da parte dell’autorità pubblica. Mentre la stesura di tali valutazioni è di fatto demandata agli sviluppatori dei sistemi e questo rischia di minare all’origine l’efficacia della norma. Al singolo cittadino europeo viene data la possibilità di richiedere spiegazioni su decisioni supposte lesive dei propri diritti, ma poco si capisce di come tale possibilità possa essere resa attiva e cogente, sia da parte della cittadinanza più marginalizzata e tanto meno da parte di cittadini extraeuropei. Il doppio standard stabilito dalla norma, inoltre, si evidenzia e si ripete anche nella possibilità di esportazione di tecnologie di Intelligenza Artificiale ritenute dannose e illegali nella UE, comprese quelle utilizzabili per il punteggio sociale 12 . Nei casi di ricorso avverso e decisioni sbagliate, dovrebbero essere incluse tra coloro che sporgono denuncia, le organizzazioni di cittadinanza attiva e sindacali, e non soltanto i singoli danneggiati. Quale esempio di studio dei danni che può produrre un sistema di IA, anche se non classificato ad alto rischio, è da citare lo scandalo delle prestazioni per l’assistenza all’infanzia in Olanda 13, in cui una IA ha erroneamente accusato decine di migliaia di genitori di aver presentato richieste fraudolente di sussidi. Al termine dell’inchiesta l’azione è stata definita “discriminatoria” nei confronti dei genitori con origini straniere, nonché piena di “pregiudizi istituzionali”.

Una particolare attenzione va rivolta alla sanità, campo nel quale le applicazioni di IA hanno un grande potenziale di utilizzo. Secondo la responsabile di ricerca Health Action International (HAI), le applicazioni di Intelligenza Artificiale utilizzate per l’assistenza clinica potrebbero potenzialmente non essere considerate sistemi ad alto rischio: “Gran parte dell’Intelligenza Artificiale che vediamo ora utilizzata in questo contesto non è classificata come dispositivo medico e quindi non sarà regolamentata come ad alto rischio, pertanto, non esistono requisiti normativi né valutazioni di conformità per questi sistemi. Si potrebbe pensare ai sistemi di Intelligenza Artificiale per la sorveglianza del comportamento o al monitoraggio dello stile di vita, e a tutti i tipi di tecnologia intelligente come materiali per l’incontinenza e letti intelligenti, che raccolgono dati estremamente sensibili e il cui malfunzionamento può danneggiare i pazienti. Riteniamo che questi sistemi non dovrebbero rimanere non regolamentati” 14 .

L’identificazione biometrica e il riconoscimento delle emozioni

Non è presente alcun divieto totale sulla identificazione biometrica e il riconoscimento delle emozioni. Nonostante gli appelli della società civile che si sono susseguiti financo al giorno stesso dell’annuncio dell’accordo, viene lasciata aperta la strada all’uso di questi sistemi in modalità pericolose, discriminatorie e di sorveglianza di massa. Le eccezioni, previste per le forze dell’ordine per la lotta alla criminalità, aprono scappatoie di vasta portata in termini di impatto sulle persone. Sia l’identificazione biometrica dal vivo che quella retrospettiva distruggono l’anonimato negli spazi pubblici. Per quanto riguarda il riconoscimento delle emozioni, questo è correttamente vietato nei luoghi di lavoro e negli ambienti educativi. Vengono però omessi dal divieto altri usi altrettanto dannosi, quali quelli nei contesti di polizia, di frontiera e di migrazione. “È difficile essere entusiasti di una legge che, per la prima volta nell’UE, ha adottato misure per legalizzare il riconoscimento facciale pubblico dal vivo in tutto il blocco”.15

La polizia predittiva

Terminologia di derivazione fantascientifica, il termine “polizia predittiva” si riferisce all’uso della Intelligenza Artificiale in determinazioni probabilistiche tese a valutare il fatto che specifici soggetti commettano reati o recidivano in essi nel futuro 16 . L’AI Act vieta l’uso dei sistemi che fanno previsioni sugli individui sulla base di tratti o caratteristiche della personalità 17, ma non vieta l’uso della previsione di criminalità su base geografica18 . Questi sistemi rafforzano modalità le razziste e discriminatorie nelle attività di polizia 19.

L’Intelligenza Artificiale per scopi generali (General purpose Artificial Intelligence – GPAI)

La IA per scopi generali o i sistemi di intelligenza artificiale senza uno scopo specifico sono principalmente soggetti a obblighi di trasparenza, non essendo previste specifiche valutazioni di rischio, requisiti di sicurezza informatica o valutazioni di terze parti quando la potenza di calcolo utilizzata nell’addestramento sia inferiore ad una certa soglia 20 . Solo i sistemi GPAI che utilizzano una potenza di calcolo superiore dovranno affrontare requisiti più severi, come la segnalazione degli incidenti e gli obblighi di sicurezza informatica. Attualmente solo il GPT-4 di OpenAI è al di sopra della soglia, Google non fornisce informazioni su Gemini.

Una veloce conclusione su un testo al di sotto delle aspettative

Siamo ancora in attesa di un testo definitivo e saranno le limature finali a dare il senso completo all’accordo. Non si può non notare che nonostante tutte le “aperture sul retro” che il testo definisce verso i desiderata dell’industria e della polizia, immediatamente dopo la proclamazione dell’accordo si siano levate voci per una sua maggiore liberalizzazione.

Per quanto riguarda la migrazione l’Europa sta già adottando metodologie di utilizzo improprio della IA e il clima politico che si respira non appare proprio in grado di limitare questa deriva. Un doppio standard rispetto alla salvaguardia dei diritti di cittadinanza che l’Europa afferma per sé, è completamente inaccettabile.

Certamente, a livello delle dichiarazioni di principio, se queste hanno un senso, l’accordo vorrebbe porre dei limiti alla pervasività del business dell Big tech, così come ad un uso improprio della IA da parte degli Stati. E tuttavia un accordo che pone “limiti con eccezioni” si configura come un testo di linee guida per gli utilizzi altrimenti definiti impropri più che come un testo di limitazione agli utilizzi scorretti.

Non casualmente il commissario all’industria Thierry Breton ha dichiarato: “L’AI Act è molto più di un regolamento: è un trampolino di lancio per le start-up e per i ricercatori dell’UE, per guidare la corsa globale all’IA“.

Come affermato da Aida Ponce del Castillo di Social Europe 21, “questo riassume il vero obiettivo perseguito dalla Commissione e dal Consiglio dell’UE fin dall’inizio del processo legislativo: sviluppare un quadro giuridico che aiuti l’UE a posizionarsi come leader globale nell’Intelligenza Artificiale, limiti il meno possibile lo sviluppo del settore e fornisca il massimo supporto alle aziende di IA che operano nella UE”.

Insomma, sempre con le parole di Ponce del Castillo, un “regolamento di deregolamentazione”.

NOTE:

1 https://eur-lex.europa.eu/legal-content/IT/TXT/HTML/?uri=CELEX:52021PC0206

2 Il meccanismo di approvazione delle norme in Unione Europea prevede l’accordo tra Consiglio di Europa (in rappresentanza dei governi), Commissione Europea (organismo di vertice europeo) e Parlamento Europeo (assemblea elettorale)

3 Chat-GPT, software di Intelligenza Artificiale reso pubblico nell’aprile del 2023, è il primo esempio di intelligenza artificiale generativa preaddestrata, dove l’acronimo GPT (Generative Pre-trained Transformer) ne sta ad indicare i “motore” sottostante . Il transformer è il modello matematico che sottende l’algoritmo, il preaddestramento è alla base della successiva capacità che il modello ha di generare, su una base statistica derivata dall’addestramento, risposte apparentemente coerenti.

4 https://newsroom.consilium.europa.eu/events/20231206-artificial-intelligence-act-trilogue

5 https://www.consilium.europa.eu/en/press/press-releases/2023/12/09/artificial-intelligence-act-council-and-parliament-

strike-a-deal-on-the-first-worldwide-rules-for-ai/, https://www.europarl.europa.eu/news/en/press-room/20231206IPR15699/

artificial-intelligence-act-deal-on-comprehensive-rules-for-trustworthy-ai, https://ec.europa.eu/commission/presscorner/api/files/document/print/en/qanda_21_1683/QANDA_21_1683_EN.pdf

6 Per modello di fondazione si intende il modello algoritmico fondante che sta dietro la tecnologia del transformer generativo.

7 https://www.asgi.it/discriminazioni/ai-eu-intelligenza-artificiale-discriminazione-asilo/, https://www.amnesty.eu/wp-content/uploads/2022/12/Open-letter_EU-AI-Act_migration_December-2022.pdf

8 Articolo 83 della Proposal for a regulation of the european parliament and of the council laying down harmonised rules on artificial intelligence (artificial intelligence act) and amending certain union legislative acts COM/2021/206 final,

9 https://www.consilium.europa.eu/en/policies/it-systems-security-justice/

10 Allegato IX della Proposal for a regulation of the european parliament and of the council laying down harmonised rules on artificial intelligence (artificial intelligence act) and amending certain union legislative acts COM/2021/206 final

13 https://en.wikipedia.org/wiki/Dutch_childcare_benefits_scandal

14 https://insideaipolicy.com/share/15518

15https://edri.org/our-work/eu-ai-act-deal-reached-but-too-soon-to-celebrate/

17 https://www.wired.com/story/eu-ai-act/

18 https://www.fairtrials.org/app/uploads/2021/11/Automating_Injustice.pdf

20 FLOPS Floating point Operations per second, indica il numero di operazioni in virgola mobile eseguita dalla CPU in un secondo. la soglia è stabilita a 1025 FLOPs.

21 https://www.socialeurope.eu/the-ai-act-deregulation-in-disguise

Franco Padella

18/1/2024 https://sbilanciamoci.info/

Tutti i collegamenti ipertestuali citati sono stati consultati in data 16/12/2023

L’autore intende ringraziare Rachele Gonelli e Mario C. Cirillo per le utili discussioni.

Lascia un Commento

Vuoi partecipare alla discussione?Sentitevi liberi di contribuire!