L’ASSISTENTE VOCALE DI APPLE: IL CALVARIO DEI DIPENDENTI

Alla fine di luglio, The Guardian e El País hanno rivelato che centinaia di persone erano incaricate di ascoltare le conversazioni degli utilizzatori di Siri, l’assistente vocale di Apple, per correggerne i risultati. Dopo aver sospeso il programma che riprenderà in autunno, la società ha appena annunciato il licenziamento di 300 dipendenti.

Mentre Apple, messa all’angolo dalle rivelazioni sugli ascolti degli utilizzatori di Siri, mette alla porta centinaia di dipendenti, Mediapart ha potuto raccogliere le testimonianze di molti di loro e ha potuto consultare dei documenti che descrivono in dettaglio il lavoro di questi impiegati, incaricati di ascoltare gli utenti.

In totale almeno 300 persone che lavoravano per dei subappaltatori di Apple a Cork, in Irlanda, si sono visti notificare la fine del loro contratto lo scorso venerdì, riporta il The Guardian mercoledì 28 agosto.

Questo annuncio non è stata una vera sorpresa per i dipendenti in questione. Dal 2 agosto molti di loro erano stati messi in disoccupazione tecnica dopo la rivelazione, del The Guardian e El País, della reale natura del loro lavoro: ascoltare gli utenti di Apple parlare a Siri. Questa intelligenza artificiale, installata sull’insieme dei dispositivi venduti dalla marca con la mela, permette di attivare applicazioni, di ascoltare musica, di fare una ricerca su internet o anche di chiamare un contatto, semplicemente attraverso un comando vocale.

Gli articoli del Guardian e di El País non erano tuttavia di loro stessi degli scoop. Diversi ricercatori avevano già spiegato che le intelligenze artificiali lo sono molto meno di quanto coloro che le hanno concepite pretendano. Incapaci di “imparare” veramente da soli, gli algoritmi hanno bisogno di centinaia di migliaia di esempi, forniti da degli esseri umani.

I due quotidiani riportano in compenso le testimonianze inedite di ex dipendenti dei subappaltatori di Apple che hanno passato le loro giornate ad ascoltare conversazioni di clienti e a valutare la risposta data da Siri. In più, rivelano, i diversi dispositivi sui quali è installata l’assistente vocale hanno la spiacevole tendenza ad attivarsi di continuo.

I dipendenti incaricati di ascoltare gli estratti sonori registrati da Siri si imbattono in questo modo regolarmente su scambi particolarmente privati, come rapporti sessuali o quello che sembrava essere un traffico di droga. Come reazione Apple aveva annunciato la sospensione dei programmi di miglioramento di Siri, il tempo di rivederli e di riprenderli, in una forma diversa, l’autunno prossimo.

Anche Mediapart ha raccolto le testimonianze di numerosi ex dipendenti che avevano lavorato nei locali di GlobeTech, una delle due principali società che lavorano per Apple a Cork (l’altra è Lionbridge). Questi confermano le informazioni del Guardian e di El País e forniscono dei dettagli supplementari.

Le centinaia di persone che lavoravano per GlobeTech e Lionbridge erano coinvolti in molteplici “progetti” corrispondenti a diverse fasi di verifica e di valutazione di Siri. Per portare a termine queste mansioni erano necessarie competenze e livelli di accreditamento differenziati che permettevano, per centinaia di queste, di accedere ai dati personali contenuti nel dispositivo dell’utente.

Dato che ogni dipendente era sottoposto ad una clausola di confidenzialità è molto difficile sapere a che cosa corrisponde esattamente ogni progetto. Ma numerosi documenti interni e testimonianze di ex dipendenti raccolte da Mediapart permettono di avere un’idea abbastanza precisa del ruolo degli umani al cuore del funzionamento dell’intelligenza artificiale e delle loro condizioni di lavoro.

I dipendenti che lavorano direttamente su Siri sono divisi in due categorie principali. Ci sono innanzitutto i «language analysts», che lavorano sui «bulk data», i dati grezzi, vale a dire gli estratti audio che non contengono altre informazioni.

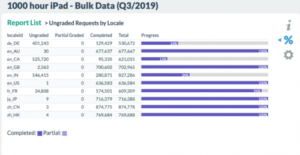

Il lavoro di base corrisponde ai programmi «1000 hours» (1000 ore) e si declina in seno di progetti specifici in funzione del dispositivo: «1000 hours iPhone», «1000 hours iPad», «1000 hours CarPlay», eccetera. Il lavoratore, connesso a un’interfaccia su una rete interna di Apple, ha accesso alla registrazione audio e, in basso, alla trascrizione automatica fatta dall’algoritmo. Deve limitarsi ad ascoltare la sequenza, chiamata «iterazione», e a correggere gli eventuali errori di trascrizione.

Il numero di iterazioni necessarie per il buon funzionamento di Siri è impressionante. Nei documenti consultati da Mediapart, una tabella di obiettivi trimestrali riporta la cifra di 609309 estratti audio per i clienti francofoni, 874778 per i Cinesi, o ancora 716388 per i Giapponesi. E questo unicamente per il terzo trimestre 2019 e per l’iPad. Ne consegue, per i lavoratori, un ritmo sfrenato per raggiungere una quota giornaliera stabilita a 1300 iterazioni al giorno.

L’altra categoria di lavoratori corrisponde ai «data analysts» i quali hanno accesso ad alcuni dati personali degli utenti. Apple aveva tuttavia affermato che i suoi dipendenti non avevano modo di identificare le persone ascoltate, in quanto non non disponevano dell’«user ID», l’identificativo.

È in parte vero. Il nome dell’utente o il suo numero non comparivano in effetti. Ma un piccolo menù integrato all’interfaccia di Apple, l’user data browser, permette di effettuare delle ricerche tra i dati contenuti nel dispositivo. Questa funzionalità è principalmente integrata allo strumento di valutazione di Siri, il Siri results widget (SRW).

Questo presenta, in alto, l’estratto audio, in basso a sinistra la risposta data da Siri alla richiesta. A destra una serie di domande permette di valutarla. E in basso, l’user data browser permette di cercare nei dati del dispositivo per verificare che Siri abbia utilizzato le informazioni corrette.

Come spiega uno dei documenti, «i dati dell’utente possono essere utili per capire l’intenzione dell’utente. Per esempio se l’utente dice: “Mostra tramonto orizzontale”, può essere difficile da capire. Però se l’utente ha un album fotografico chiamato “Tramonti orizzontali” quello che voleva dire diventa chiaro».

Per quanto riguarda le condizioni di lavoro, i dipendenti dei subappaltatori di Apple sono migliori rispetto a quelle di molti altri micro-lavoratori, come quelle descritte dal sociologo Antonio Casilli, autore del libro En attendant les robots (Seuil, gennaio 2019) e membro del progetto DipLab (Digital Platform Labor), all’origine del rapporto «Le micro-travail en France», uscito in aprile 2019.

Questo nuovo sottoproletariato digitale, questi «cottimisti del Web» spesso lavorano da casa loro, attraverso delle piattaforme intermediarie, e spesso non conoscono nemmeno l’identità del committente. Sono retribuiti a cottimo, la maggior parte delle volte qualche centesimo di euro.

Alla GlobeTech i dipendenti dispongono di un contratto di lavoro di diritto irlandese, con uno stipendio mensile lordo di circa 2.000 euro al mese, per delle giornate lavorative di 7 ore e 30, pausa pranzo esclusa, con due pause di 15 minuti. Lavorano in dei locali specifici da dove si collegano all’interfaccia Apple tramite una rete sicura.

Le condizioni di lavoro sono rigide e spesso mal vissute dai dipendenti. «La parte peggiore è l’aspetto ripetitivo, le iterazioni che continuano a ripetersi, come ad esempio “metti la sveglia a quell’ora” spiega Antoine*, uno degli ex dipendenti che Mediapart ha incontrato. Le persone erano tutte laureate, dai 3 ai 5 anni di studi universitari. Si annoiavano tutti. La maggior parte delle persone se ne andavano il prima possibile, non appena finivano la loro quota giornaliera di iterazioni. Credo che nessuno resti per più di sei mesi. Anche i nostri superiori sembravano odiare il loro lavoro.».

«Inoltre», continua Antoine*, «eravamo spaventatissimi. Quando non analizzavamo un’iterazione per più di sei minuti eravamo considerati in pausa. Era necessario inviare ogni sera via mail il numero di iterazioni che si erano fatte durante la giornata». «Potevamo essere licenziati da un giorno all’altro», conferma Gaël*, un altro ex dipendente. La sera, il tuo supervisore poteva arrivare da te per dirti: “non hai raggiunto le tue statistiche oggi, te ne vai”».

Molti dipendenti hanno vissuto male il fatto di essere testimoni della vita privata degli utenti. Una buona parte delle richieste sono ordini piuttosto classici, come chiamare un contatto. «Il più divertente che mi è capitato è stato un “chiama Frank Riester”1», ricorda Antoine.

Ma alcuni sono particolarmente invadenti. «Molte persone dettano i loro messaggi. E ci sono quindi molti messaggi di sexting», racconta Antoine. Ci sono allo stesso modo il caso di richieste di ricerca relative a delle malattie per esempio. «Si sentono anche spesso voci di bambini. Non abbiamo chiesto il loro permesso, a loro!», s’indigna Gaël, che si ricorda di una voce infantile che chiedeva: «Ascolta Siri, mi puoi mostrare una foto di un pisello vero?».

Ci sono poi molte persone che usano Siri come dittafono per registrare delle note vocali. Antoine e Gaël si sono così entrambi imbattuti più volte su degli estratti di professori, che registravano il loro parere sul consiglio di classe.

E poi, le registrazioni accidentali, provocate da un avvio involontario di Siri. Perché l’assistente vocale sembra essere particolarmente sensibile. «Si attiva di continuo», conferma Antoine. «Ho notato che funzionava anche con le frasi di altri assistenti vocali, per esempio se dite “OK Google”».

Quando un dipendente si imbatteva su una di queste registrazioni, doveva ascoltarla e segnalarla cliccando su un «accidental trigger». «Era decisamente il tasto che cliccavamo di più», ricorda Antoine. «Potevamo sentire di tutto. Poteva essere della musica di un’auto per vari minuti o due adolescenti che si raccontavano i loro drammi». Anche Gaël si è imbattuto varie volte su dei litigi amorosi, su delle confessioni intime…

A volte il disagio sentito dal dipendente si trasforma in trauma. Alcuni lavoratori possono confrontarsi con delle registrazioni che rivelano pratiche illegali o situazioni di violenza. «Mi ricordo di una ragazza che diceva alla sua amica, probabilmente a proposito del suo ragazzo, una cosa del tipo: “è pericoloso, bisogna farlo rinchiudere”. In questi casi qui non sai cosa fare, non si sa se sia una situazione di reale pericolo». Gaël invece ricorda di una registrazione in cui un uomo faceva espliciti commenti pedofili. “Mi ha fatto infuriare», ricorda. «Abbiamo un dovere morale dal momento in cui sorvegliamo? Non è che c’è un crimine di complicità?».

Nella home page del portale di aiuto messo a disposizione dei dipendenti Apple, un messaggio li avverte che possono trovarsi di fronte a «commenti volgari, violenti, pornografici o criminali» e li incoraggia a contattare il proprio supervisore se necessario. Però, nella pratica, i dipendenti non hanno informazioni su quello che succede dopo.

«Questo tipo di traumi è abbastanza comune», spiega Antonio Casilli. «Alcuni lavoratori possono persino soffrire di disturbi post-traumatici da stress, in particolare quelli responsabili della moderazione dei commenti. I moderatori di Microsoft e Facebook hanno già citato in giudizio i loro datori di lavoro dopo essere stati colpiti da questa sindrome. Nel contesto dei revisori di Siri – continua il sociologo – c’è un ulteriore fattore in gioco: la difficoltà di contestualizzazione. Si confrontano con estratti di discussioni, dichiarazioni isolate, totalmente sradicate dal contesto generale. Non possono sapere se si tratta di una provocazione o di un’esagerazione. Questo può essere più inquietante che se fossero stati fisicamente presenti.»

Nei suoi lavori Antonio Casilli ha dimostrato quanto siano essenziali i micro-lavoratori per il corretto funzionamento delle intelligenze artificiali. In questo caso, quali misure adotterà Apple? La mela ha annunciato al Guardian che il programma di rating di Siri riprenderà in autunno, con alcune modifiche. In particolare, gli utenti potranno specificare che rifiutano di essere ascoltati e i responsabili dell’ascolto delle clip audio saranno assunti direttamente da Apple.

Antonio Casilli prende questi annunci «con molto sospetto». «Il lavoro di queste persone è fondamentale per il funzionamento di un assistente vocale», sottolinea. «L’intelligenza artificiale deve essere addestrata e verificata. Altrimenti, non funziona. Dovranno quindi inventare un nuovo modo di fare questa formazione e verifica. La soluzione di internalizzare questi compiti imporrebbe, in particolare, vincoli di maggiore riservatezza. Ma questo andrebbe semplicemente contro i principi di gestione di Apple. Un’altra soluzione potrebbe essere quella di frammentare ulteriormente i compiti di formazione e verifica e assegnarli a centri di gestione in paesi terzi», continua il sociologo. «Negli ultimi mesi c’è stata un’ondata di rivelazioni, con diversi lavoratori che si sono trasformati in informatori. E sembra che la maggior parte di essi provengano da paesi dell’Unione europea, dove le leggi sono più protettive che altrove. Possiamo immaginare che Apple possa cercare di localizzare i propri centri di gestione in paesi con una legislazione meno clemente».

Anche Gaël è convinto che il programma riprenderà a breve, forse internamente. «Modificheranno semplicemente i termini e le condizioni d’uso per includere il fatto che quello che dici a Siri può essere ascoltato. La gente firmerà e ricomincerà», predice. «Purtroppo, è decisamente possibile», concorda Antonio Casilli. Siamo tutti schiavi del consenso forzato delle CGU. Sono perfettamente in grado di mettere in ciò che solo ieri era inimmaginabile».

Le rivelazioni degli ultimi mesi, tuttavia, segnano un innegabile punto di svolta. Il 13 agosto, anche Facebook ha ammesso di ascoltare le conversazioni degli utenti delle funzionalità audio del suo servizio Messenger e ha annunciato la loro sospensione. Apple, da parte sua, si è scusata con i suoi clienti giovedì 29 agosto.

“Tutti i Gafam sono stati smascherati”, constata Antonio Casilli. «Solo un anno fa, se in una conferenza dicevo che i lavoratori ascoltano ciò che si dice a un assistente vocale, era una “educated guess”, un’assunzione illuminata, una logica conseguenza di ciò che avevo capito del loro funzionamento durante le mie ricerche».

«Da allora, c’è stata una valanga di testimonianze che dimostrano che non solo ci sono registrazioni selvagge, ma anche che questi assistenti vocali sono estremamente difettosi», continua il sociologo. Quando vedi tassi di precisione del 90%, si può dire che è già abbastanza non male, ma significa comunque che quando chiedi le indicazioni sulla strada da seguire, una volta su dieci l’algoritmo sbaglierà. È ancora un problema. Apple ha quindi mentito due volte: dicendo che non hanno registrato le persone e dicendo loro che Siri funziona.»

JÉRÔME HOURDEAUX

4/9/2019 www.euronomade.info

*i nomi sono stati cambiati

(Traduzione di Clara Mogno)

Questo articolo è stato pubblicato su MediaPart il 31 agosto 2019.

Versione francese: Assistant vocal d’Apple: le calvaire des salariés

Lascia un Commento

Vuoi partecipare alla discussione?Sentitevi liberi di contribuire!