L’Intelligenza artificiale? È razzista e sessista

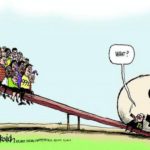

Dobbiamo farci i conti, è inutile arroccarsi su posizioni conservatrici e negazioniste. L’Intelligenza artificiale (IA) fa già parte del nostro presente e, che ci piaccia o no, farà innegabilmente parte del nostro futuro. Quindi a noi che resta da fare? Metterci l’animo in pace, di base, e però capire come poterla utilizzare al meglio perché ci sia di supporto e non di ostacolo e perché non diventi un palliativo alla mancanza di intelligenza umana. Perché ricordiamolo, dietro l’IA ci siamo ancora e sempre noi: nel programmarla, nel fornirle elementi per velocizzare analisi complesse e processi complicati, nel darle indicazioni su come “comportarsi”.

Facciamo un esempio, e nello specifico quello analizzato da Pratyusha Ria Kalluri, studentessa presso l’Università di Stanford in California. Che si è resa conto di una cosa alquanto interessante: i generatori di immagini che si basano su tecnologie di IA troppo spesso producono risultati sessisti e razzisti. E questo è evidentemente un riflesso della cultura che sta alla base della programmazione di questi strumenti, e inevitabilmente va a perpetuare le sue influenze sulla ricerca scientifica, dove l’IA è ampiamente utilizzata.

Ma cos’ha fatto la studentessa per rendersi conto di questo, chiamiamolo così, “bug del sistema”? Ha provato, utilizzando una popolare app che crea immagini, a chiedere di produrre l’immagine di un “uomo americano a casa propria”. Risultato? Maschio bianco davanti a una maison in stile coloniale. Ok, riproviamo: “uomo africano davanti alla sua bella casa”. Ci risiamo. Eccolo qui, un uomo con la pelle scura davanti alla sua bellacapanna.

Valeva la pena indagare. Kalluri e colleghi hanno scoperto come le immagini generate da Stable Diffusion, modello di apprendimento profondo che genera immagini da descrizioni testuali, si ispirino in maniera inequivocabile a comunissimi stereotipi, come per esempio l’associazione Africa = povertà, o povertà = persona con la pelle scura. Anzi, fa addirittura di peggio: persona che si occupa della casa = donna nera; assistente di volo = donna; vigile del fuoco = uomo; pilota = uomo bianco, e potremmo andare avanti ancora.In pratica, l’IA crea immagini che spesso non rispecchiano nemmeno le proporzioni demografiche reali, ma si basa su “stereotipi amplificati” che producono immaginari tipicamente correlati tra gli altri a pregiudizi di genere, colore della pelle, occupazione e nazionalità. E lo conferma anche uno studio di «The Lancet» che si focalizza sulla salute globale (Reflections before the storm: the AI reproduction of biased imagery in global health) e che, per fare un esempio su tutti, rileva come l’IA associ la descrizione “Medico nero africano che aiuta bambini poveri e malati bianchi” produca un’immagine fuorviante e stereotipata del “salvatore bianco” circondato da bambini dalla pelle scura, nonostante la descrizione pesantemente evidenzi una situazione contraria a quella poi raffigurata.

Tutto questo ci sorprende? Mica tanto. Di fatto la nostra società è intrisa di questi stereotipi: diversi studi hanno evidenziato come, anche senza l’IA, le immagini associate a certe descrizioni siano spesso condizionate da stereotipi di genere, sesso e razza. E i modelli di IA vengono “allenati” a comportarsi in un certo modo basandosi su migliaia di immagini presenti online che non sono solo stereotipate, ma spesso contengono elementi problematici come per esempio abusi su minori e nudità di persone non consenzienti. E in un mondo che sempre più si affida alle immagini senza badare più di tanto, o per niente, alle descrizioni testuali, questo si configura come un problema estremamente serio, se consideriamo che l’uso dell’IA è in aumento anche in contesti scientifici, oltre che per popolare il web di finzioni visive. Insomma, occorre considerare, come d’altronde segnalato anche da un report dell’UNESCO intitolato “2022 Recommendation on the Ethics of Artificial Intelligence” che l’Intelligenza artificiale deve per forza di cose muoversi di pari passo con un codice etico che consideri la riproposizione o la generazione di pregiudizi come uno dei problemi più urgenti da affrontare. Anche perché non è così scontato quale sia il risultato più “giusto”.

Una delle possibili strade da percorrere sarebbe quella di rendere sempre più open source i database da cui l’IA trae materiali e di cui si “nutre”. In questo modo si riuscirebbe per lo meno ad avere accesso agli elementi che creano quei problemi legati a chiavi di lettura e “tag” preimpostati, incompleti e condizionati spesso da soggetti privati, e che hanno fatto emergere criticità già una decina di anni fa, quando apparvero i primi generatori di immagini.

Per ora si suggeriscono alcuni trucchi di tamponamento: uno di questi può essere inserire, nella descrizione da cui vogliamo ricavare l’immagine, una specifica del tipo “se tutti gli individui possono essere assistenti di volo, senza limitazioni di colore della pelle, …” ma anche questo non sempre funziona, perché rischia di portare la generazione di immagini completamente al suo opposto (= tutti gli assistenti di volo sono di pelle scura).

Un’altra strada possibile è quella di utilizzare generatori di immagini che permettono a loro volta di utilizzare altre immagini come suggerimento di partenza, anche se di fatto così si bypassa il problema, senza davvero affrontarne le radici, e si addossa tutta la responsabilità all’utilizzatore finale che spesso non riconosce nemmeno quei pregiudizi perché inconsciamente si trova di fronte a un’immagine “che riconosce” come affine al suo immaginario.

Indubbiamente si tratta di una questione impellente e spinosa: l’IA sta prendendo sempre più il sopravvento in moltissimi ambiti, e gestire milioni di dati è costoso in termini economici e temporali. È quindi estremamente urgente gestire questi immensi database con regole che richiedono per forza di cose una presenza umana e coinvolta, che sappia aprire il più possibile strade a una ricerca aperta e scevra da pregiudizi ripetuti e, ancora peggio, automatizzati, e che tenga anche conto di un paio di domande sociali niente affatto banali. Quale sarebbe l’output ideale? L’IA deve riflettere la realtà, anche se questa è ingiusta?

Anna Molinari

20/5/2024 https://www.unimondo.org/

Lascia un Commento

Vuoi partecipare alla discussione?Sentitevi liberi di contribuire!